Вы подготовили идеальный материал, запустили новую категорию товаров или опубликовали важную новость, но трафика нет, а позиции остаются пустыми. Причина почти всегда кроется в технической задержке со стороны поисковых систем, которые просто не успели добавить ваши страницы в свою базу данных. В условиях жесткой конкуренции на рынке Казахстана ждать две или три недели, пока робот сам обнаружит новый контент, означает терять деньги и отдавать клиентов более расторопным конкурентам.

Проблема «долгой индексации» касается всех, от небольших блогов до крупных e-commerce платформ, и решение этой задачи требует системного подхода, а не простого нажатия одной кнопки. Мы разберем, как ускорить индексацию сайта белыми методами, используя технический инструментарий, поведенческие факторы и прямую коммуникацию с поисковыми системами.

Что такое индексация и почему скорость критически важна

Индексация представляет собой процесс добавления сведений о странице в базу данных поисковой системы, после чего этот URL становится доступным для выдачи пользователям по соответствующим запросам. Важно понимать разницу между сканированием и индексацией, так как многие владельцы сайтов путают эти понятия: сканирование (краулинг) означает, что робот посетил страницу, а индексация означает, что он сохранил ее в базе.

Если краулер зашел на сайт, но счел контент вторичным, технически некорректным или малополезным, страница может остаться в статусе «Просканировано, но не проиндексировано», что является одной из самых частых проблем в SEO на сегодняшний день. Скорость попадания в индекс напрямую влияет на окупаемость контента: чем быстрее статья или карточка товара появится в выдаче, тем быстрее вы начнете получать органический трафик и лиды, особенно если речь идет о сезонных предложениях или новостной повестке.

В Казахстане, где доля Google преобладает, но Яндекс сохраняет сильные позиции в коммерческом секторе, необходимо работать сразу с двумя системами, у каждой из которых свои алгоритмы и приоритеты при обходе новых документов.

Пошаговый алгоритм: как загнать страницу в поиск

Как провести технический аудит доступности страницы перед отправкой?

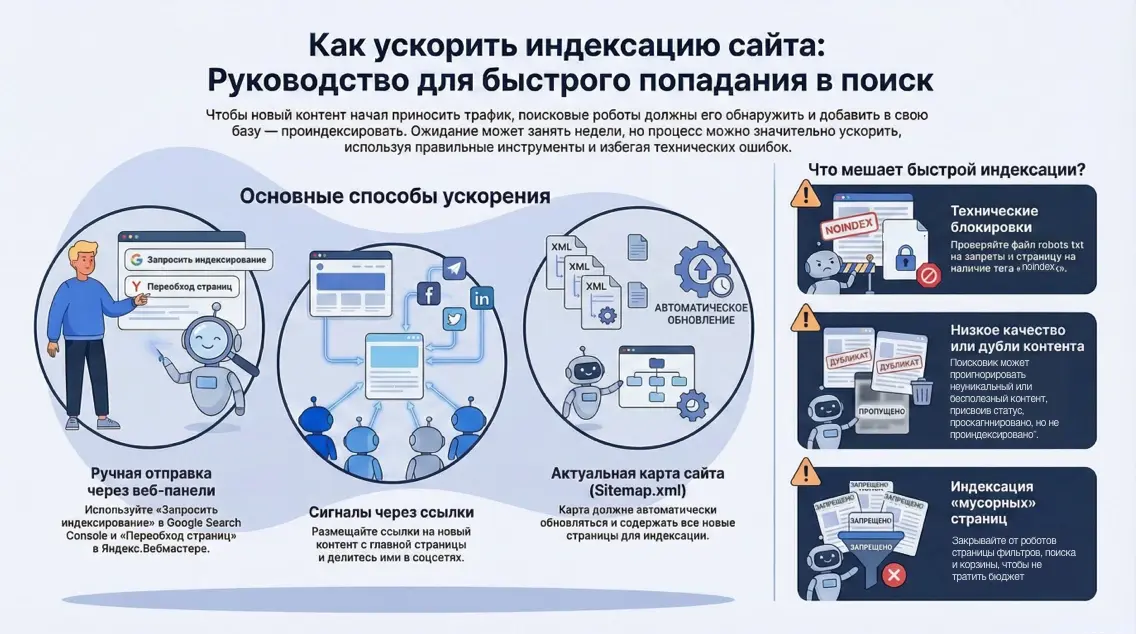

Перед тем как пытаться принудительно звать роботов на сайт, необходимо убедиться, что дверь для них действительно открыта, иначе вы просто потратите лимиты краулингового бюджета впустую. Первым делом проверяется код ответа сервера, который для доступной страницы обязан быть строго 200 OK, так как любые редиректы (301, 302) или ошибки (404, 5xx) остановят процесс индексации в самом начале.

Далее следует внимательно изучить файл robots.txt на предмет случайных блокирующих директив Disallow, которые могли остаться после разработки или тестирования, а также проверить исходный код самой страницы на наличие мета-тега noindex в блоке head или в HTTP-заголовке X-Robots-Tag.

Еще один критический нюанс заключается в настройке канонических ссылок (rel="canonical"): страница должна ссылаться сама на себя, подтверждая, что она является оригиналом, а не дублем другой версии контента. Если вы отправляете на индексацию неканоническую страницу, Google с высокой вероятностью проигнорирует запрос, посчитав, что вы предлагаете ему дублированный контент, что в долгосрочной перспективе может даже навредить авторитету домена.

Как правильно отправить запрос через Google Search Console?

Ручная отправка URL через Google Search Console остается самым надежным базовым методом для единичных страниц, который позволяет явно сигнализировать поисковику о появлении нового контента. Процесс начинается с того, что вы вводите полный адрес новой страницы в верхнюю строку поиска внутри интерфейса GSC и нажимаете Enter, после чего система проводит живую проверку доступности URL. Если страница еще не в индексе, вы увидите серый статус и кнопку «Запросить индексирование», нажатие на которую ставит ваш URL в приоритетную очередь на сканирование.

Важно помнить, что этот инструмент имеет суточные лимиты, которые обычно варьируются в пределах 10-15 запросов на один ресурс, поэтому использовать его для массовой заливки тысяч товаров бессмысленно и технически невозможно. После отправки запроса робот обычно посещает страницу в течение нескольких часов, но фактическое появление в выдаче может занять от 12 до 48 часов в зависимости от общей загруженности серверов Google и авторитетности вашего домена. Регулярное использование этого метода для ключевых страниц помогает «приучить» робота заходить на сайт чаще, но злоупотреблять им для низкокачественных страниц не стоит, чтобы не расходовать доверие поисковой системы.

Как использовать инструмент «Переобход страниц» в Яндекс.Вебмастере?

Яндекс обладает собственным инструментом для ускорения индексации, который часто работает даже эффективнее и быстрее своего американского аналога благодаря так называемому «быстророботу». В панели Яндекс.Вебмастера необходимо зайти в раздел «Индексирование» и выбрать пункт «Переобход страниц», где открывается поле для ввода списка URL, которые вы хотите добавить в очередь.

Преимущество Яндекса заключается в том, что он позволяет добавлять до 20, 30 или даже больше адресов в сутки в зависимости от качества вашего сайта и показателя ИКС (Индекс Качества Сайта), что делает этот инструмент пригодным для небольших пакетных обновлений. После отправки заявки робот Яндекса, отвечающий за свежий контент, посещает страницы молниеносно, и в некоторых случаях новый материал может появиться в результатах поиска уже через несколько часов или даже минут, если речь идет о новостном ресурсе. Однако стоит учитывать, что «быстроробот» часто выбрасывает страницы из индекса спустя пару дней, если основной робот не подтвердит их качество и полезность, поэтому контент должен быть действительно ценным и уникальным.

Зачем нужны файлы Sitemap и как их правильно обновлять?

Карта сайта sitemap.xml служит основным навигатором для поисковых роботов, сообщая им обо всех страницах ресурса, которые вы считаете важными и достойными индексации. Простого наличия файла недостаточно: критически важно, чтобы он обновлялся автоматически сразу после публикации нового контента и содержал корректную дату последнего изменения в теге lastmod.

Поисковые системы, особенно Google, ориентируются на атрибут lastmod, чтобы понимать, изменилась ли страница с момента последнего визита, и если дата не актуализируется, робот может игнорировать URL месяцами. После обновления карты сайта рекомендуется принудительно сообщить об этом поисковикам, используя функцию «ping» — отправку специального GET-запроса, который уведомляет систему о том, что карта изменилась и ее следует перечитать. В Google Search Console также необходимо убедиться, что ссылка на sitemap.xml добавлена в соответствующий раздел и статус обработки файла не содержит ошибок, так как любые технические сбои в карте могут заблокировать индексацию целых разделов сайта.

Как работает перелинковка и почему вес главной страницы так важен?

Внутренняя перелинковка является одним из самых мощных сигналов для поисковых систем о важности конкретной страницы, так как роботы путешествуют по сайту именно по ссылкам. Если новая страница создана, но на нее не ведет ни одна ссылка с других разделов вашего ресурса, она становится «тупиковой» или «сиротой» (orphan page), что резко снижает шансы на быструю индексацию.

Самый эффективный метод ускорения - временно разместить ссылку на новый материал на главной странице сайта, так как главная обычно имеет максимальный ссылочный вес и чаще всего посещается краулерами. Также отлично работают сквозные блоки «Новинки», «Популярное» или «Свежие статьи» в сайдбаре или футере, которые гарантируют, что робот наткнется на ссылку при обходе любой другой страницы ресурса. Грамотно выстроенная структура, где любой документ доступен не более чем в 3 клика от главной, обеспечивает естественную и быструю индексацию без необходимости постоянного ручного вмешательства.

Как внешние сигналы и соцсети влияют на скорость робота?

Поисковые системы, особенно Google, внимательно следят за социальными сигналами и переходами из внешних источников, воспринимая их как маркер актуальности и востребованности контента. Когда ссылка на новую страницу появляется в Twitter, Telegram, Facebook или LinkedIn и по ней начинают переходить живые пользователи, это служит триггером для краулера: «здесь происходит что-то интересное, нужно срочно проверить».

Для ускорения индексации рекомендуется сразу после публикации делать посевы анонсов в своих социальных сетях, профильных сообществах и мессенджерах. Особую роль играет Google Business Profile (бывший Google Мой Бизнес): создание поста-новости с кнопкой и ссылкой на новую страницу внутри этой платформы дает прямой сигнал в экосистему Google, что часто приводит к мгновенному попаданию в индекс. Даже если ссылки из соцсетей закрыты атрибутом nofollow и не передают ссылочный вес, они передают так называемый «трафиковый сигнал», который заставляет роботов шевелиться быстрее и повышает доверие к новому URL.

Что такое IndexNow и протокол Google Indexing API?

Для продвинутых вебмастеров и владельцев сайтов с большим объемом контента существуют автоматизированные протоколы, которые позволяют общаться с поисковиками напрямую через API, минуя стандартные очереди сканирования. Протокол IndexNow, поддерживаемый Яндексом и Bing, позволяет автоматически уведомлять поисковые системы о появлении, обновлении или удалении страниц мгновенно, без ожидания планового обхода.

Для Google существует отдельный инструмент — Indexing API, который официально предназначен для сайтов с вакансиями (JobPosting) и прямыми эфирами (Broadcast), но на практике многие SEO-специалисты успешно используют его для ускорения индексации обычных страниц, хотя это требует аккуратности и технической компетенции. Настройка этих протоколов требует вмешательства разработчика или установки специальных плагинов для CMS (например, для WordPress), но результат оправдывает усилия: время от публикации до появления в поиске сокращается до минимума, а процесс становится полностью автономным.

Сравнение альтернатив: плюсы и минусы подходов

Выбор метода ускорения индексации зависит от масштаба вашего проекта, технических возможностей и частоты обновлений контента. Не существует единой «серебряной пули», и чаще всего приходится комбинировать разные подходы для достижения максимального результата. Ниже мы разберем сильные и слабые стороны основных стратегий, чтобы вы могли выбрать оптимальный вариант для своего бизнеса.

Ручная отправка через панели вебмастеров Этот метод является классическим и самым надежным для небольших сайтов или штучных публикаций важных статей.

- Плюсы: Полный контроль над процессом, бесплатность, официальный и безопасный метод, возможность сразу увидеть технические ошибки при проверке URL.

- Минусы: Жесткие суточные лимиты (10-20 URL), невозможность масштабирования для крупных магазинов, необходимость ручного труда менеджера или SEO-специалиста.

Усиление внутренними и внешними ссылками Естественный метод, который работает на долгосрочную перспективу и улучшает общую структуру сайта.

- Плюсы: Повышает авторитет страниц, улучшает поведенческие факторы, не имеет лимитов, работает автоматически при правильной настройке CMS (блоки «Новинки»).

- Минусы: Требует времени на реализацию, результат не мгновенный (робот должен сначала дойти до ссылающейся страницы), зависит от общего траста домена.

Автоматизация через API (IndexNow / Google Indexing API) Технологичный подход для крупных порталов, новостников и агрегаторов.

- Плюсы: Максимальная скорость (real-time), полная автоматизация без участия человека, возможность обрабатывать тысячи URL ежедневно.

- Минусы: Требует участия программиста для настройки, Google API официально ограничен узкими типами контента (риск санкций при злоупотреблении), сложность диагностики в случае сбоев.

Цена и сроки: сколько стоит быть первым

Вопрос стоимости ускорения индексации обычно сводится к затратам рабочего времени специалистов, так как официальные инструменты поисковых систем (GSC, Яндекс.Вебмастер) предоставляются бесплатно. Если вы владелец малого бизнеса и делаете все самостоятельно, ваши инвестиции — это 15–20 минут времени на каждый новый материал для ручного прогона по чеклисту. Однако для крупных проектов, где ежедневно генерируются сотни страниц, ручной труд становится экономически нецелесообразным, и требуется привлечение SEO-специалиста или разработчика. Настройка автоматической индексации через IndexNow или API на рынке Казахстана может стоить от 50 000 ₸ до 150 000 ₸ в качестве разовой проектной задачи, в зависимости от используемой CMS и сложности серверной архитектуры.

Существуют также платные сторонние сервисы-«индексаторы», которые обещают загнать ссылки в индекс за деньги, используя сети ботов или подставные сайты для простановки ссылок. Стоимость таких услуг варьируется от 5 ₸ до 50 ₸ за одну ссылку, но использование «серых» схем несет в себе риски и редко рекомендуется для белых проектов, нацеленных на долгосрочное развитие. Что касается сроков, то при использовании белых методов (ручная отправка + соцсети) нормальным считается появление страницы в поиске Google через 12–24 часа, а в Яндексе — от 3 часов до суток. Если страница не входит в индекс дольше 3 дней после принудительной отправки, это сигнал о наличии качественных или технических проблем, которые не решаются простым ожиданием.

Ошибки и риски, как избежать

Что означает статус «Просканировано — пока не проиндексировано»?

Этот статус в Google Search Console является настоящим бичом современного SEO и означает, что робот посетил страницу, технически смог ее прочитать, но принял решение не добавлять ее в индекс. Чаще всего причина кроется в низком качестве контента (по мнению алгоритма), отсутствии уникальной ценности или проблемах с общей авторитетностью сайта (краулинговый бюджет расходуется на мусор). Чтобы избежать этого, не плодите пустые страницы, следите за уникальностью текстов и наращивайте ссылочную массу домена, чтобы Google считал ваш ресурс достаточно важным для хранения всех его документов.

Почему опасно открывать технические страницы для роботов?

Одной из грубых ошибок является открытие для индексации технических разделов: страниц фильтрации, сортировок, результатов внутреннего поиска, корзин и личных кабинетов. Попадание тысяч таких мусорных страниц в индекс «размывает» релевантность сайта и съедает краулинговый бюджет, в результате чего робот перестает заходить на действительно важные продуктовые страницы. Используйте файл robots.txt и мета-тег noindex для жесткого закрытия всего служебного контента, оставляя роботу только то, что полезно пользователю из поиска.

Как дубли контента убивают индексацию?

Если на вашем сайте одна и та же статья доступна по разным URL (например, с параметрами UTM-меток или в разных категориях) и не настроен Canonical, поисковик видит это как попытку манипуляции или просто как беспорядок. В таких случаях алгоритм может выкинуть из индекса обе версии или выбрать случайную, которая вам не подходит. Всегда проверяйте доступность страницы только по одному чистому URL, настраивайте 301 редиректы с версий «слэш на конце / без слэша» и HTTP/HTTPS, чтобы не путать роботов.

Кейс: запуск категории товаров интернет-магазина в Алматы

Рассмотрим ситуацию с локальным интернет-магазином электроники, который к «Черной пятнице» добавил новую категорию «Умный дом» с 50 новыми карточками товаров. Без дополнительных действий новые товары могли бы индексироваться 2–3 недели, пропустив пик распродаж.

Задача: Обеспечить появление всех 50 страниц в поиске Google и Яндекс за 24 часа до старта акции.

Решение:

- Техническая база: Проверен sitemap.xml, убедились, что новые URL попали в файл с актуальной датой lastmod.

- Яндекс: Список из 50 URL был разбит на два дня (из-за лимитов) и загружен через «Переобход страниц». Приоритетные товары (флагманы) ушли в первую очередь.

- Google: 10 ключевых товаров отправлены вручную через GSC. Для остальных была создана новость в блоге магазина «Обзор новинок умного дома» со ссылками на карточки.

- Внешние сигналы: Ссылка на категорию и новость опубликована в Telegram-канале магазина и в Instagram Stories.

- Внутренний вес: В меню сайта временно добавлен пункт «Новинки» с выделением цветом, ведущий на категорию.

Результат: Через 6 часов после действий «быстроробот» Яндекса проиндексировал 42 из 50 товаров. В Google через 20 часов в индексе появились 10 вручную отправленных страниц и статья-обзор. Остальные карточки «подтянулись» через ссылки из статьи в течение 48 часов. Трафик пошел уже на первый день акции, что принесло магазину дополнительную выручку около 1 200 000 ₸, которая была бы утеряна при пассивном ожидании.

FAQ: частые вопросы по индексации

Почему Google не индексирует сайт, хотя ошибок нет?

Даже при отсутствии технических ошибок Google может не индексировать сайт, если он новый и не имеет внешних ссылок (доверия). Также причиной может быть низкое качество контента или алгоритм считает, что в интернете уже достаточно информации на эту тему и ваша страница не несет добавленной стоимости.

Помогает ли контекстная реклама ускорить SEO-индексацию?

Прямой связи между запуском Google Ads или Яндекс.Директ и органической индексацией нет, так как это разные базы данных и алгоритмы. Однако платный трафик улучшает поведенческие факторы (пользователи заходят, читают, взаимодействуют), что косвенно может ускорить внимание роботов к странице.

Как часто нужно обновлять карту сайта sitemap.xml?

Карта сайта должна обновляться в режиме реального времени или минимум раз в сутки, если на сайте происходят изменения. Статичная карта, которая не меняется месяцами при добавлении новых статей, бесполезна и может игнорироваться поисковыми системами.

Влияет ли скорость загрузки страницы на индексацию?

Да, скорость загрузки критически влияет на краулинговый бюджет: если сервер отвечает долго, робот успеет обойти меньше страниц за выделенный лимит времени. Медленные сайты индексируются хуже и медленнее, так как поисковик экономит свои ресурсы.

Можно ли использовать Indexing API для обычного блога?

Официально Google разрешает использовать API только для вакансий и прямых эфиров, но технически метод работает для любых страниц. Многие SEO-специалисты используют его на свой страх и риск для блогов, и пока массовых санкций за это не наблюдалось, но гарантий безопасности Google не дает.

Что делать, если страницу выкинуло из индекса?

Если страница была в поиске, но пропала, проверьте ее на доступность (код 200), наличие случайного тега noindex и уникальность контента (не украли ли его более мощные сайты). Часто вылет из индекса — это сигнал о том, что страница потеряла качество или актуальность в глазах алгоритма.

Заключение

Ускорение индексации - это управляемый технический процесс, который перестает быть магией, как только вы начинаете понимать логику работы поисковых роботов. В 2026 году просто создать контент уже недостаточно, необходимо активно «продавать» его поисковым системам, используя весь доступный арсенал: от ручных инструментов Google Search Console и Яндекс.Вебмастера до работы с внешними сигналами и внутренней структурой сайта. Системный подход к индексации позволяет бизнесу быстрее тестировать гипотезы, оперативнее получать трафик на сезонные предложения и не терять выручку из-за технических задержек.

Если вы сталкиваетесь с тем, что ваши страницы месяцами не попадают в выдачу, или вам нужна помощь в настройке сложной автоматизации индексации через API, команда маркетингового агентства Метриум готова провести глубокий аудит и наладить эти процессы. Мы помогаем бизнесу в Казахстане выстраивать технически безупречное SEO, которое работает на результат, в рамках наших услуг создание сайтов и SEO-продвижение.

Рекомендуем также изучить другие материалы в нашем блоге, где мы детально разбираем вопросы технической оптимизации и веб-аналитики для роста вашего бизнеса.