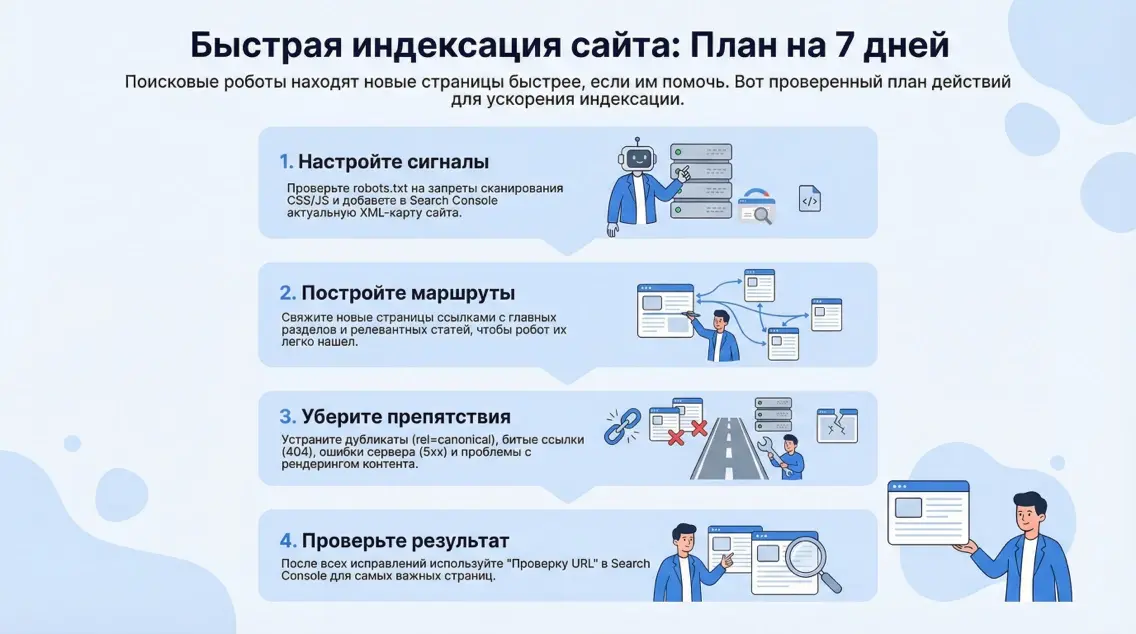

Бизнесу важна скорость появления новых страниц в поиске. Речь о практичном плане, как ускорить индексацию сайта без трюков и сомнительных плагинов. Мы работаем для владельцев и маркетологов, кому важны заявки, а не мифы. Здесь, в этой статье, мы собрали актуальный рабочий порядок действий на 7 дней, с опорой на Google Search Console, карту сайта XML, корректный robots.txt, внутреннюю перелинковку и контроль технических ошибок.

В Казахстане доля Google в поиске остаётся высокой, поэтому акцент на инструментах Google, но альтернативы тоже разберём. По данным StatCounter за последние 12 месяцев Google держит основную часть рынка - более 90%, тогда как Яндекс занимает гораздо меньшую долю - менее 10%, поэтому приоритет - Google, а затем дополнительные каналы.

Что это и зачем

В этой части коротко определим задачу: индексация - это добавление страниц в базу поисковой системы, а не ранжирование. Ускорить индексацию сайта значит сделать так, чтобы поисковик быстрее обнаружил, просканировал, отрендерил и занёс URL в индекс. На скорость влияют доступность страниц для обхода и рендеринга, сигналы карты сайта, внутренняя и внешняя связность, отсутствие блокировок на уровне robots и мета-директив, а также отсутствие технического мусора вроде 404, 410 и 5xx на целевых URL.

Базовые определения и лучший старт дают официальные руководства Google Search Central, где подчёркнуто, что поисковик находит новые URL главным образом по ссылкам и по сайтмапам, а приоритет — корректная архитектура, а не костыли.

Что именно важно понимать об индексации сегодня?

Индексация не гарантируется по кнопке. Запрос на переобход в Search Console может помочь, но не является обязательством со стороны Google. Куда важнее, чтобы ссылки вели к новым страницам, чтобы файл sitemap.xml был доступен и обновлялся с релевантным lastmod, чтобы критичные ресурсы CSS и JS не блокировались в robots, а сервер корректно отвечал кодами 200, 304, 404 или 410 там, где это уместно. Google прямо говорит, что ссылки используются для нахождения новых страниц, сайтмапы помогают систематизировать открытые к сканированию URL, а priority и changefreq в XML не влияют на индексацию.

Для JS-сайтов принципиально, чтобы робот мог отрендерить контент, поэтому запреты на CSS и JS допускаются только если отсутствие ресурсов не мешает пониманию контента. Подача сигналов через Indexing API разрешена для ограниченных типов страниц, поэтому универсальная стратегия опирается на архитектуру сайта, внутренние ссылки, сайтмапы, корректные директивы и стабильную работу сервера.

Пошагово как сделать за 7 дней

Перед началом убедитесь, что домен подтверждён в Search Console и карта сайта уже доступна по стабильному URL. Если нет - сделайте это в День 1.

День 1: Как быстро навести порядок в robots.txt и карте сайта?

Начните с проверки robots.txt на корне домена. Нельзя закрывать от Googlebot важные разделы, а также базовые директории с CSS и JS, если их блокировка мешает корректному рендерингу. Оставьте запреты только для технических зон и дублей, а для статики убедитесь, что блокировок нет или они не влияют на понимание контента роботом. Далее опубликуйте и добавьте в Search Console карту сайта XML с актуальными URL и корректными lastmod. Не пытайтесь манипулировать priority и changefreq, у Google они не учитываются, сосредоточьтесь на полноте и актуальности. Если карта сайта большая, используйте индексный сайтмап. Пинг сайтмапов вручную уже не нужен, так заявлено официально, достаточно один раз отправить в Search Console и обновлять файл при изменениях. В конце дня проверяйте статус обработки в разделе Sitemaps, убирайте 404 в карте сайта, и не держите в ней закрытые от индексации URL. Основа создана, блокировок нет, сайтмап отражает реальность, значит всё готово для ускоренного обнаружения новых страниц.

День 2: Как связать новые страницы ссылками, чтобы их нашли быстрее?

Сделайте внутреннюю перелинковку. Добавьте ссылки на новые страницы из навигации, релевантных статей и категорий, проставьте хлебные крошки и блоки рекомендаций. Важны кликабельные, индексируемые ссылки с понятным анкором, ведущие с уже посещаемых роботом страниц. Избегайте осиротевших URL, когда на страницу вообще ничто не ссылается. Используйте отчёты краулера и экспорт из CMS, чтобы находить осиротевшие страницы и возвращать их в структуру. Чем выше по иерархии ссылка на новый материал, тем быстрее его найдут. Не увлекайтесь массовым добавлением одинаковых блоков ссылок на всех страницах, это размывает сигнал и снижает приоритет. Логика простая: сначала получите маршрут к новинкам с высокопосещаемых хабов, потом закрепите двумя-тремя естественными ссылками из контента и навигации. Такой подход усиливает вероятность скорого сканирования и попадания в индекс без искусственных трюков и не требует большого бюджета.

День 3: Как исключить канонические ловушки и дубли, тормозящие индексацию?

Проверьте rel=canonical на новых и шаблонных страницах. Каноникал должен указывать на индексируемую версию, а не на себя в параметрических вариантах с UTM. Закройте параметрические и технические URL через noindex при необходимости, но не путайте noindex с Disallow в robots, это разные механизмы. Если вы Disallow закрыли путь, робот может не увидеть мета noindex и продолжит считать страницу потенциально пригодной, пока не встретит явный сигнал. Стандартизируйте пагинацию, фильтры и сортировки, не создавайте тысячи слабых дублей.

Выведите в карту сайта только основные канонические URL. Если раздел переезжал, используйте корректные 301-редиректы. Уберите soft 404, когда страница формально отдаёт 200, но по сути пуста. Пройдитесь по шаблонам и убедитесь, что нет конфликтов каноникала, hreflang и пагинации. Это снижает шум для робота и ускоряет попадание нужной версии в индекс.

День 4: Как помочь роботу с экономией краулингового бюджета на сервере?

Настройте корректные заголовки кеширования и условные запросы. Для неизменившегося контента сервер должен возвращать 304 Not Modified при наличии валидных ETag или Last-Modified, это экономит время и трафик краулера, увеличивая шанс быстро дойти до новых страниц. Проверьте скорость ответа и стабильность, исключите частые 5xx, они замедляют сканирование и снижают доверие к хосту. Перераздайте тяжелые страницы кэшем, но не ломайте доступность контента для рендеринга.

Проверьте, что для картинок и статики применяются разумные политики кеша, а для HTML нет агрессивного кеширования, которое возвращает старые версии после публикации. Эта дисциплина даёт предсказуемость для робота: он тратит меньше ресурсов на старое и быстрее доходит до нового, что прямо влияет на скорость появления свежих материалов в индексе.

День 5: Как безопасно обращаться с 404, 410 и редиректами, чтобы не терять время робота?

Проверьте все новые и изменённые URL на корректность ответов сервера. Если страница удалена навсегда, 410 предпочтительнее, чем 404 с пустым шаблоном, это ускоряет переоценку и освобождает ресурсы. Не делайте цепочки 301 по нескольку прыжков подряд, каждый лишний переход забирает бюджет. Для временно недоступных страниц избегайте 503 без Retry-After на долгий срок. Не маскируйте ошибки 404 шаблоном с кодом 200, такие soft 404 мешают индексации и сбивают сигнал качества.

В карте сайта не должно быть отсутствующих страниц, иначе робот тратит время на пустое. Контролируйте эти моменты в отчёте Page indexing и в логах веб-сервера, чтобы видеть, куда робот ходит впустую. Чистая картина кодов и краткие редиректы системно ускоряют работу краулера.

День 6: Как убедиться, что рендеринг не блокируется и контент виден роботу?

Проверьте, что критичные ресурсы не закрыты в robots и что страница рендерится роботом так же, как у пользователя. JS-фреймворки допустимы, но важно, чтобы контент был доступен без сложных клиентских действий. Если часть контента подгружается лениво, убедитесь, что HTML содержит минимум необходимой информации, а ключевые блоки не зависят от событий, недоступных роботу. При необходимости используйте серверный рендеринг или гибридные подходы. Если вы закрывали CSS и JS из соображений скорости, пересмотрите эти запреты, Google прямо предупреждает, что блокировка важных ресурсов мешает пониманию страницы.

Сверяйте рендер по руководствам JavaScript SEO и не принимайте на веру устаревшие советы старых плагинов или форумов. Цель проста: робот должен видеть то же, что и пользователь, тогда индексация проходит предсказуемо.

День 7: Как корректно инициировать переобход и масштабировать контроль?

Когда архитектура и сигналы готовы, используйте URL Inspection в Search Console точечно для самых важных новых страниц. Эта функция ограничена по квоте, поэтому применяйте её к приоритетным URL, а не к сотням записей подряд. Для мониторинга статуса используйте отчёты Page indexing и, при необходимости, URL Inspection API в рамках допустимых лимитов. Помните, что повторные отправки одного и того же URL не ускоряют процесс.

Сфокусируйтесь на причинах неиндексации, которые показывают отчёты, и устраняйте их. Массовые костыли уступают системной архитектуре и чистому индексационному следу. По итогам недели у вас должен быть воспроизводимый процесс, который работает и без ручных кнопок.

Сравнение альтернатив: плюсы и минусы

Нужно ли использовать Indexing API и сервисы пинга?

Indexing API официально предназначен для двух типов контента: JobPosting и трансляции с BroadcastEvent внутри VideoObject. Для обычных страниц использовать его нельзя. Плагины, обещающие мгновенную индексацию всего сайта через этот API, идут вразрез с рекомендациями Google.

В экосистеме Яндекса и Bing работает протокол IndexNow, который уведомляет поисковики о новых URL, и его можно включить в рабочий процесс для этих систем.

В Казахстане основная доля органики приходит из Google, поэтому IndexNow рассматривайте как дополнительный канал, а не как замену архитектурным основам. Реальная выгода достигается не из-за кнопки пинга, а из-за правильной структуры, сайтмапов и доступности контента для рендеринга.

Цена и сроки, факторы влияния

Во сколько обойдется быстрый запуск и что влияет на срок?

Сроки. При чистой технической базе первые новые страницы обычно попадают в индекс за 1-7 дней, но при слабой перелинковке и блокировках процесс растягивается.

Стоимость. Практический пакет на неделю включает аудит robots и сайтмапа, настройку перелинковки, исправление дублей и кодов ответов, настройку кэш-заголовков, точечные запросы на переобход и еженедельный отчёт.

В Казахстане рыночная стоимость подобных работ у агентств и частных специалистов колеблется в широком диапазоне в зависимости от масштаба и стека: от 250 000 ₸ до 900 000 ₸ за быстрый спринт, для крупных сайтов дороже.

На сроки сильнее всего влияют доступность ресурсов для рендеринга, отсутствие 5xx при обходе, качество внутренней сети ссылок, а также дисциплина обновления карты сайта.

Прямая покупка ссылок ради ускорения индексации не решает технических проблем и часто добавляет риски.

Ошибки и риски

Чем опасен robots.txt и когда он ломает индексацию?

Главная ошибка - путать disallow и noindex. Disallow запрещает сканирование, но не гарантирует исключение URL из поиска, особенно если на него активно ссылаются. Мета noindex оценивается роботом только при сканировании, поэтому закрытый Disallow раздел может годами висеть в отчётах.

Второй типовой провал - закрыть в robots критичные CSS и JS, из-за чего робот не понимает контент и помечает его как проблемный.

Третий - поддерживать карту сайта с несуществующими страницами и 404, заставляя краулер тратить бюджет впустую.

Четвёртый - держать бесконечные параметрические копии, которые размножают мусор. Лекарство одно: минимальные запреты, полные сайтмапы, чистые коды ответов, каноникал на целевые версии и проверка рендеринга.

Эти вещи прямо описаны в руководствах Google и подтверждаются опытом быстрых внедрений.

Что делать с 404, 410 и 5xx при ускорении?

Не бойтесь 404 для реально отсутствующих страниц, это нормальный сигнал. Если страница удалена окончательно, верните 410, чтобы подсказать поисковику не тратить время. Избегайте цепочек 301 и петлей, держите один шаг до целевой версии. Следите за стабильностью сервера, серии 5xx снижают темп обхода.

В отчёте Page indexing закрывайте soft 404 и очистите сайтмап от битых URL. Если раздел переносили, убедитесь, что не осталось старых ссылок в навигации и хлебных крошках.

Совокупность этих мелочей экономит краулинговый бюджет, и робот быстрее доходит до новых материалов, что повышает шанс скорого появления в индексе.

Кейс: магазин в Алматы

Как 7-дневный план сработал на новом каталоге?

Исходные данные: интернет-магазин в Алматы, 1 800 SKU, новая категория на 120 товаров. До внедрения сайтмап содержал 180 устаревших URL и дубли с UTM, внутренняя перелинковка отсутствовала, часть CSS закрыта в robots, отчёт Page indexing фиксировал soft 404.

Кратко план действий на 7 дней:

День 1 - привели robots и сайтмап, удалили мусор и отправили актуальный файл.

День 2 - добавили ссылки с хабовых категорий и статей, собрали блоки рекомендаций.

День 3 - навели порядок с каноникалом и пагинацией, убрали параметрические дубли.

День 4 - включили корректные ETag и Last-Modified, стабилизировали коды. День 5 закрыли soft 404 и коротко настроили редиректы.

День 6 - проверили рендеринг и открыли нужные ресурсы.

День 7 - отправили точечные запросы на переобход по верхним 20 SKU и новым листингам.

Результат. За 72 часа в индекс попали карточки с наивысшей связностью, за 5 дней был проиндексирован листинг категории, к концу недели в индексе оказались 93 из 120 карточек, оставшиеся подтянулись после второго обновления сайтмапа и дополнительных ссылок.

Ключевые факторы успеха - чистая карта сайта, отсутствие блокировок и сильные внутренние ссылки.

FAQ: частые вопросы по индексации сайта

Почему страница не индексируется, хотя я нажал Request Indexing в Search Console

Кнопка не гарантирует индексацию. Проверьте доступность для сканирования, рендеринг, отсутствие noindex и дублей, а также наличие внутренних ссылок и запись в сайтмапе.

Нужно ли заполнять priority и changefreq в сайтмапе

Нет, Google эти поля не использует. Сосредоточьтесь на корректных URL и актуальном lastmod.

Поможет ли Indexing API ускорить индексацию обычных страниц

Нет, API официально для JobPosting и livestream. Для остальных типов используйте архитектуру, сайтмапы и перелинковку.

Можно ли блокировать CSS и JS в robots ради скорости

Только если отсутствие ресурсов не мешает пониманию страницы. В большинстве случаев блокировать нельзя.

Нужно ли вручную пинговать сайтмап каждый раз

Нет, ручной пинг сайтмапов устарел и не требуется. Достаточно отправки в Search Console и актуализации файла.

Есть ли смысл подключать IndexNow для Яндекса и Bing

Да, это быстрый дополнительный сигнал, но в Казахстане основная доля трафика приходит из Google, поэтому считайте IndexNow вспомогательным инструментом.

Заключение

Индексация ускоряется за счёт системной архитектуры, а не из-за секретных кнопок. Чистый robots, актуальный сайтмап, связная внутренняя сеть, корректные коды и предсказуемый рендеринг дают быстрый результат.

Семидневный план превращается в повторяемый процесс: вы публикуете контент, а поисковик быстро его находит и индексирует. Нужна реализация под ваш стек и бизнес-цели - обращайтесь в маркетинговое агентство Метриум, наши специалисты соберут рабочий процесс для вашего сайта.